Un nuevo estudio muestra por qué los modelos de AI de razonamiento simulado aún no están a la altura de su facturación

La Olimpiada de Matemáticas de EE. UU. (Usamo) sirve como un calificador para la Olimpiada Internacional de Matemáticas y presenta una barra mucho más alta que las pruebas como la Examen de matemáticas de invitaciones estadounidenses (Aime). Si bien los problemas de AIME son difíciles, requieren respuestas enteras. Usamo exige que los concursantes escriban pruebas matemáticas completas, obtenidas por la corrección, la integridad y la claridad durante nueve horas y dos días.

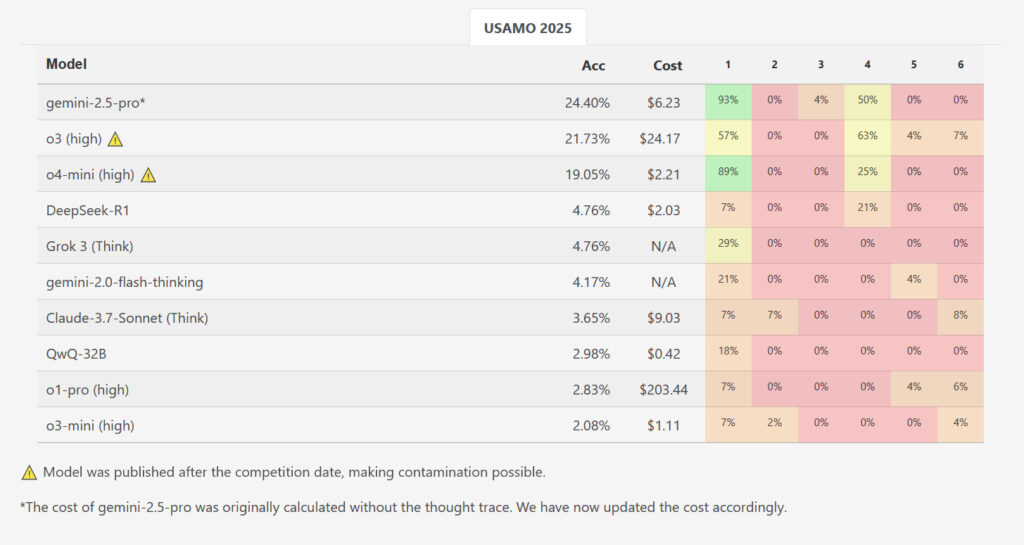

Los investigadores evaluaron varios modelos de razonamiento de IA en los seis problemas del USAMO 2025 poco después de su lanzamiento, minimizando cualquier posibilidad de que los problemas fueran parte de los datos de entrenamiento de los modelos. Estos modelos incluían Qwen’s QWQ-32B, Deepseek r1Google’s Gemini 2.0 Flash Considering (experimental) y Géminis 2.5 ProfessionalOperai’s O1-Professional y O3-MiniAnthrope’s Soneto Claude 3.7 con pensamiento extendidoy xai’s Grok 3.

Mientras que un modelo, Gemini 2.5 Professional de Google, logró un puntaje promedio más alto de 10.1 de 42 puntos (~ 24 por ciento), los resultados mostraron una caída de rendimiento masiva en comparación con los puntos de referencia a nivel de AIME. Los otros modelos evaluados se retrasaron considerablemente más atrás: Deepseek R1 y Grok 3 promediaron 2.0 puntos cada uno, el pensamiento flash de Google obtuvo 1.8, Claude 3.7 de Anthrope logró 1.5, mientras que QWQ de Qwen y O1-Professional OpenAI promediaron 1.2 puntos. O3-Mini de OpenAI tuvo el puntaje promedio más bajo en solo 0.9 puntos (~ 2.1 por ciento). De casi 200 soluciones generadas en todos los modelos y ejecuciones probados, ni una sola recibió una puntuación perfecta para ningún problema.

Mientras que el recién lanzado de Openai 03 y O4-Mini-Excessive no fueron examinados para este estudio, puntos de referencia en los investigadores ‘ Matharena El sitio net muestra O3-Excessive anotando 21.73 por ciento en basic y O4-Mini-Excessive anotando 19.05 por ciento en basic en Usamo. Sin embargo, esos resultados están potencialmente contaminados porque se midieron después de que se realizó el concurso, lo que significa que los modelos más nuevos de Operai podrían haber incluido las soluciones en los datos de capacitación.

Cómo fallaron los modelos

En el documento, los investigadores identificaron varios patrones clave de falla recurrente. Las salidas de IA contenían brechas lógicas donde faltaba justificación matemática, incluían argumentos basados en supuestos no probados y continuó produciendo enfoques incorrectos a pesar de generar resultados contradictorios.

Un ejemplo específico involucrado USAMO 2025 Problema 5. Este problema pidió a los modelos que encontraran todos los números enteros positivos «Okay», de modo que un cálculo específico que involucra sumas de coeficientes binomiales elevados al poder de «Okay» siempre daría como resultado un entero, sin importar qué entero positivo «n» se usara. Sobre este problema, el modelo QWQ de Qwen cometió un error notable: excluyó incorrectamente las posibilidades no enteras en una etapa donde la declaración del problema les permitía. Este error llevó al modelo a una respuesta remaining incorrecta a pesar de haber identificado correctamente las condiciones necesarias antes en su proceso de razonamiento.