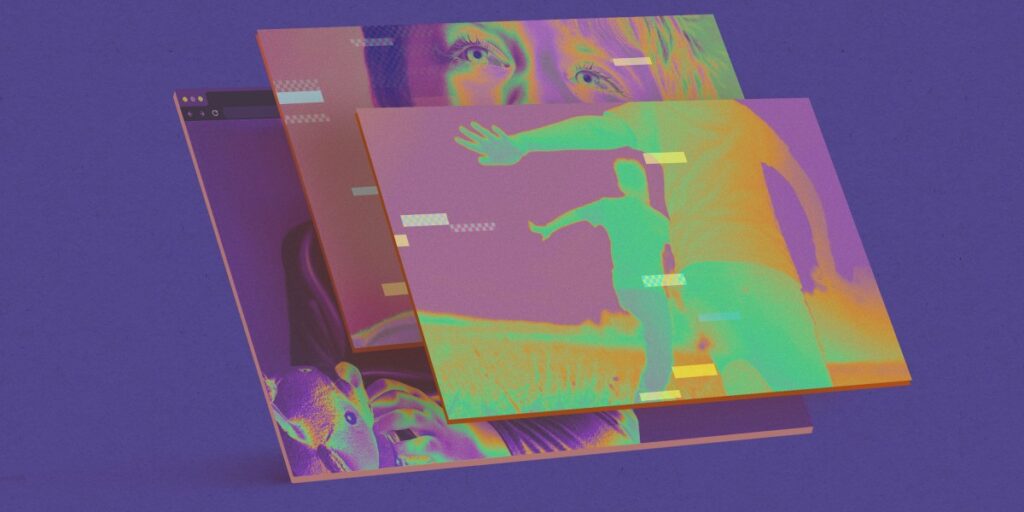

Los investigadores estadounidenses están utilizando AI para detectar imágenes de abuso infantil hechas por AI

El presentaciónpublicado el 19 de septiembre, es muy redactado y el cofundador y el CEO de Hive Kevin Guo le dijeron Revisión de la tecnología del MIT que no pudo discutir los detalles del contrato, pero confirmó que implica el uso de los algoritmos de detección de IA de la compañía para el materials de abuso sexual infantil (CSAM).

Las cotizaciones de presentación datos del Centro Nacional para los Niños Faltantes y Explotados que informaron un aumento del 1.325% en incidentes que involucran IA generativa en 2024. «El gran volumen de contenido digital que circula en línea requiere el uso de herramientas automatizadas para procesar y analizar datos de manera eficiente», se lee en la solicitud.

La primera prioridad de los investigadores de explotación infantil es encontrar y evitar que ocurra cualquier abuso que ocurra actualmente, pero la avalancha de CSAM generado por IA ha dificultado que los investigadores sepan si las imágenes representan una verdadera víctima actualmente en riesgo. Una herramienta que podría marcar con éxito las víctimas reales sería una gran ayuda cuando intenten priorizar los casos.

Identificar imágenes generadas por IA «asegura que los recursos de investigación se centren en casos que involucran víctimas reales, maximizando el impacto del programa y salvaguardar a las personas vulnerables», se lee en la presentación.

Hive AI ofrece herramientas de IA que crean movies e imágenes, así como una variedad de herramientas de moderación de contenido que pueden marcar la violencia, el correo no deseado y el materials sexual e incluso identificar a las celebridades. En diciembre, Revisión de la tecnología del MIT reportado que la compañía estaba vendiendo su tecnología de detección de Deepfake al ejército estadounidense.